Vor dem Hintergrund der Kommunikationsüberwachung durch Geheimdienste stellt sich immer wieder die Frage, wie viel des Internets überhaupt überwacht werden. Der deutsche Auslandsgeheimdienst BND darf maximal 20% des Auslandsverkehrs überwachen, heißt es. Und die NSA behauptet selbst, gar nur 1,6% des Internet-Verkehrs zu überwachen.

Aber was bedeutet das wirklich? Wird damit nur ein kleiner Teil abgehört? Nein. Die Dienste können damit alles überwachen. Alles.

Bei den 20%, die der BND überwachen darf, ist das relativ einfach: Das G10 Gesetz spricht [Anmerkung: Stand 2014!] in § 10 Abs. 4 klar vom „Anteil der auf diesen Übertragungswegen zur Verfügung stehenden Übertragungskapazität“, ähnliches sagt auch Michael Hartmann gegenüber der Zeit. Sprich: der BND darf nicht 100% der Maximalkapazität einer Verbindung überwachen, sondern nur 20% (und diese auch nur auf Stichwörter durchsuchen, § 4 Abs. 2 G10 Gesetz).

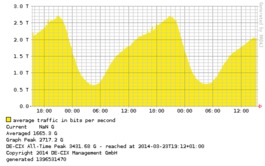

In der Praxis sieht das dann so aus: Der weltgrößte Internet-Austauschpunkt DE-CIX in Frankfurt hat eine Gesamtkapazität von 12 Terabit/Sekunde. Von diesen darf eine Stichprobe von 20% also 2,4 Terabit/Sekunde durchsucht werden.  Dann schauen wir uns doch mal die Traffic-Statistik vom DE-CIX an. Die Statistik liegt üblicherweise nur Abends ca. zwischen 19 und 22 Uhr geringfügig über diesen 2,4 TBit/Sec, ansonsten meist darunter. Nun weiß ich natürlich nicht, welche Technik der BND am DE-CIX einsetzt (und ob er dort überhaupt etwas einsetzt, wovon aber auszugehen ist). Aber wenn er technisch dazu in der Lage ist: Rein rechtlich kann der BND nahezu 100% vom Datenverkehr abgreifen und nach Stichwörtern durchsuchen. Und wenn man das großzügig interpretiert, dann wird die zur Verfügung stehende Kapazität eben auf einen ganzen Tag gemittelt, dann hat der BND auf jeden Fall 100% der Daten, die er dann weiter analysieren darf.

Dann schauen wir uns doch mal die Traffic-Statistik vom DE-CIX an. Die Statistik liegt üblicherweise nur Abends ca. zwischen 19 und 22 Uhr geringfügig über diesen 2,4 TBit/Sec, ansonsten meist darunter. Nun weiß ich natürlich nicht, welche Technik der BND am DE-CIX einsetzt (und ob er dort überhaupt etwas einsetzt, wovon aber auszugehen ist). Aber wenn er technisch dazu in der Lage ist: Rein rechtlich kann der BND nahezu 100% vom Datenverkehr abgreifen und nach Stichwörtern durchsuchen. Und wenn man das großzügig interpretiert, dann wird die zur Verfügung stehende Kapazität eben auf einen ganzen Tag gemittelt, dann hat der BND auf jeden Fall 100% der Daten, die er dann weiter analysieren darf.

Am DE-CIX läuft natürlich nicht nur Auslands-Traffic auf, der Großteil dürfte Inlands-Traffic sein. Damit hat der BND erst recht 100% vom Auslands-Traffic.

NSA analysiert nur 1,6% des Datenverkehrs?

Die NSA gibt sich wie gesagt weitaus harmloser (Kasten auf Seite 6). Nur 1,6% des Datenverkehrs würden analysiert, rund 30 Terabyte pro Tag.

Wenig? Nein, würden sie mehr analysieren, wären sie auch ziemlich dämlich.

Um der Datenmenge Herr zu werden, muss man intelligent und selektiv vorgehen. Der Großteil des Internet-Traffics besteht aus Videos von Youtube, Netflix und anderen Diensten. Es ist also naheliegend, dass die IP-Adressen der entsprechenden Video-Server gleich weggefiltert und gar nicht weiter analysiert werden. Selbst wenn sich die NSA dafür interessiert, wer wann welches Youtube-Video anschaut, ist es nicht nötig die Videos zu speichern: die Adresse der dazugehörigen HTML-Seite reicht.

Bei „normalen“ Webseiten ist das ähnlich: ein Großteil der Datenmenge einzelner Seiten besteht aus Bildern, Werbebannern, JavaScript für irgendwelchen Schnickschnack, Stylesheets für die Optik. Alles uninteressant, gleich weg damit. Und auch hier ist es nur nötig die Adresse der Webseite zu speichern. Aber selbst wenn man den Inhalt haben will, reichen wenige Teile. Beispielsweise für diesen Artikel würde das bedeuten: Ein normaler Nutzer lädt rund 1 MB Daten – oder ca. 200 KB wenn einiges aus dem lokalen Cache kommt – aus dem Netz herunter. Die HTML-Seite hat während der per gzip komprimierten Übertragung nur 18 KB. Das sind maximal 10% der insgesamt heruntergeladenen Daten. Oder gar nur knapp 2%, wenn nichts im lokalen Cache liegt.

Obige Darstellung ist natürlich sehr vereinfacht und darüber welche Inhalte die NSA in diesem Falle konkret interessiert kann man nur spekulieren. Aber: warum sollten sie die Bannerwerbung speichern? Warum sollten sie zig tausendmal den gleichen Artikel von Spiegel Online abspeichern? Warum alle Bilder in diesem?

Sprich: vor der Analyse und bevor in die Inhalte rein geschaut wird, wird selektiert: IP-Adress-Bereiche, von denen die Server Videos, Anzeigen, Bilder und andere statische Daten ausliefern, werden sofort verworfen. Das näher zu untersuchen würde nur Rechenzeit kosten. Die verbliebenen Daten werden genauer untersucht, und auch da wird alles, was nicht interessant ist, sofort weggeworfen. Und das sollte möglichst viel sein: ; bei dieser Webseite hier interessieren auch nicht Bilder, Stylesheets (Angaben zur optischen Darstellung) und ähnliches. Am Ende bleiben 30 TB Daten pro Tag übrig. Diese kann man gut ein paar Tage aufbewahren, um die wichtigen Meta-Daten (z.B. Web-Adressen und wer wann mit wem Kommuniziert hat) zu extrahieren und zur weiteren Analyse bereit zu halten. Kommunikationsdaten (wie beispielsweise E-Mails usw.) machen insgesamt nur einen sehr kleinen Teil des Datenverkehrs aus – und lässt sich daher auch problemlos länger aufbewahren.

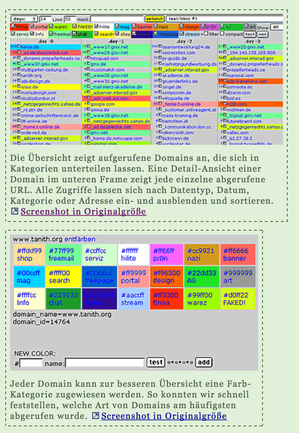

Alternativ ließe sich ein vorselektierter Teil-Datenstrom gleich mit einem Tool wie urlsnarf untersuchen. Das extrahiert alle aufgerufenen URLs (Web-Adressen): in Echtzeit. Als Nebenprodukt meiner Diplomarbeit habe ich das in anderem und kleinem Rahmen (und nicht mit urlsnarf) bereits 2000 gemacht: 100% Metadatenaufzeichnung in Echtzeit, gespeichert in einer SQL-Datenbank zur sofortigen Weiterverarbeitung (siehe auch Screenshot vom Interface).

Alternativ ließe sich ein vorselektierter Teil-Datenstrom gleich mit einem Tool wie urlsnarf untersuchen. Das extrahiert alle aufgerufenen URLs (Web-Adressen): in Echtzeit. Als Nebenprodukt meiner Diplomarbeit habe ich das in anderem und kleinem Rahmen (und nicht mit urlsnarf) bereits 2000 gemacht: 100% Metadatenaufzeichnung in Echtzeit, gespeichert in einer SQL-Datenbank zur sofortigen Weiterverarbeitung (siehe auch Screenshot vom Interface).

Wenn die NSA nun also behauptet, sie würden nur 1,6% des Internet-Traffics untersuchen, dann stimmt das sicherlich. Dennoch überwachen und protokollieren sie eben alles. Alles, was sie in die Hände kriegen und was relevant ist. Der irrelevante Rest sofort weggeworfen, übrig bleiben 1,6%.

Kommentare